ДИСТИЛЛЯЦИЯ РИЗОНИНГА В МАЛЫЕ ЯЗЫКОВЫЕ МОДЕЛИ

Опубликовано: 12.12.2025

Опубликовано в выпуске:

СВ1(2025)КНИИТМУ (55)

Рассмотрен подход к дистилляции (переносу знаний) рассуждающих способностей от большой языковой модели-учителя к малой языковой модели-ученику. Описан метод создания датасета, содержащего различные типы рассуждений (Chain-of-Thought, Program-of-Thought, Skip-Thinking), и процесс дообучения малой модели с использованием этого датасета и техники LoRA. Целью работы является демонстрация снижения вычислительной сложности нейросети за счет передачи сложных навыков рассуждения от мощной модели к более компактной.

eLIBRARY.RU Наше издание в Научной Электронной Библиотеке eLIBRARY.RU

eLIBRARY.RU Наше издание в Научной Электронной Библиотеке eLIBRARY.RU

Публикационная активность журнала РИНЦ

Публикационная активность журнала РИНЦ

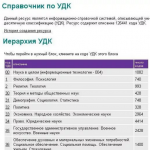

Справочник по УДК Ресурс описывает универсальную десятичную классификацию (УДК)

Справочник по УДК Ресурс описывает универсальную десятичную классификацию (УДК)

Антиплагиат Система автоматической проверки текстов на наличие заимствований

Антиплагиат Система автоматической проверки текстов на наличие заимствований

МГТУ имени Н. Э. Баумана официальный сайт университета

МГТУ имени Н. Э. Баумана официальный сайт университета